Categories

Money money money...

Could we help you? Please click the banners. We are young and desperately need the money

Wie man das ILO einrichtet und ein RAID erstellt, bei HPE.

ILO

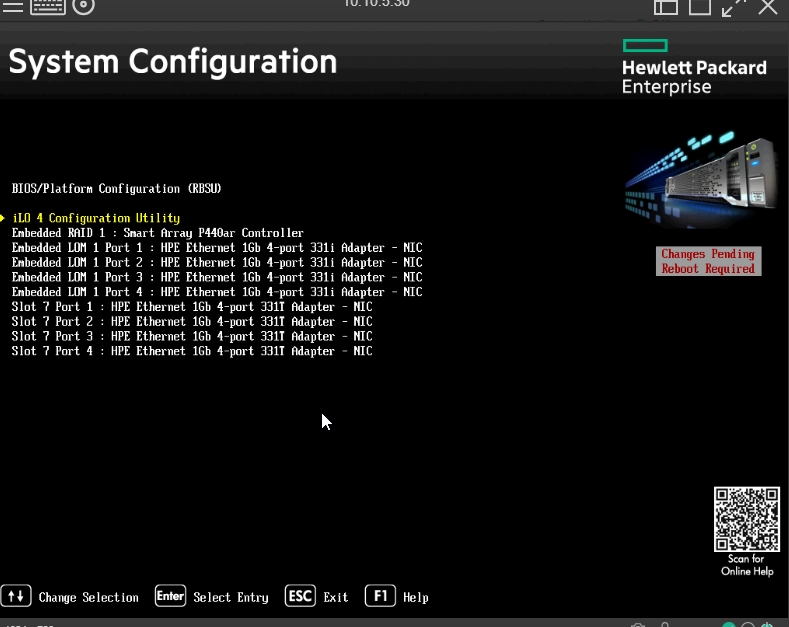

- Drücken Sie F9 beim Bootvorgang um in die System Configuration zu kommen.

- Wählen Sie die Option ILO Configuration Utlility.

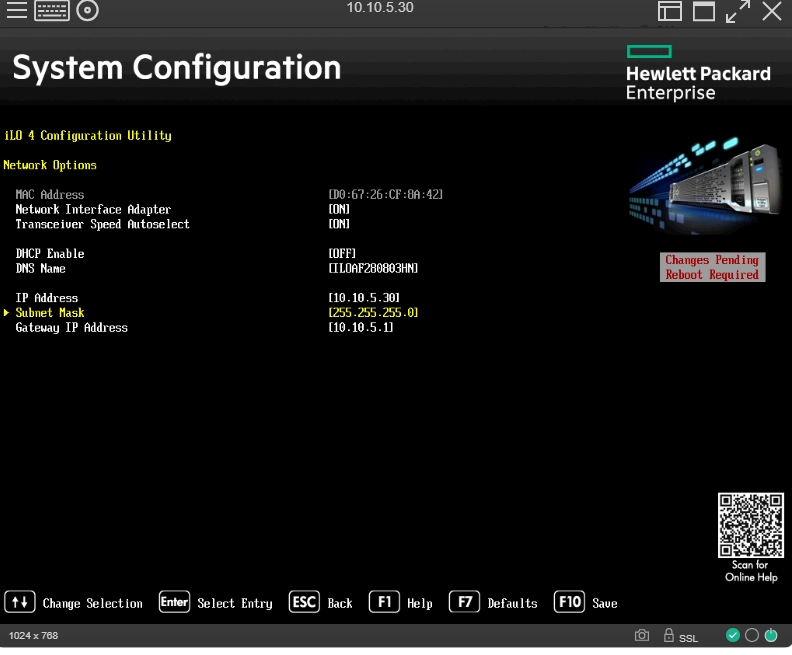

- Gehen Sie auf Network Options.

Falls Sie das ILO komplett zurücksetzen wollen gehen Sie auf Reset ILO - Hier können Sie eine fixe IP vergeben.(empfohlen)

Geben Sie dem ILO eine fixe IP und DNS Namen.

- Wählen Sie bei Punkt 3 User Management aus

- Edit/Remove User

- Action Edit

- Passwort ändern

RAID konfigurieren:

- Wie oben F9-> System Configuration, dann Embedded RAID 1: Smart Array P440ar Controller.

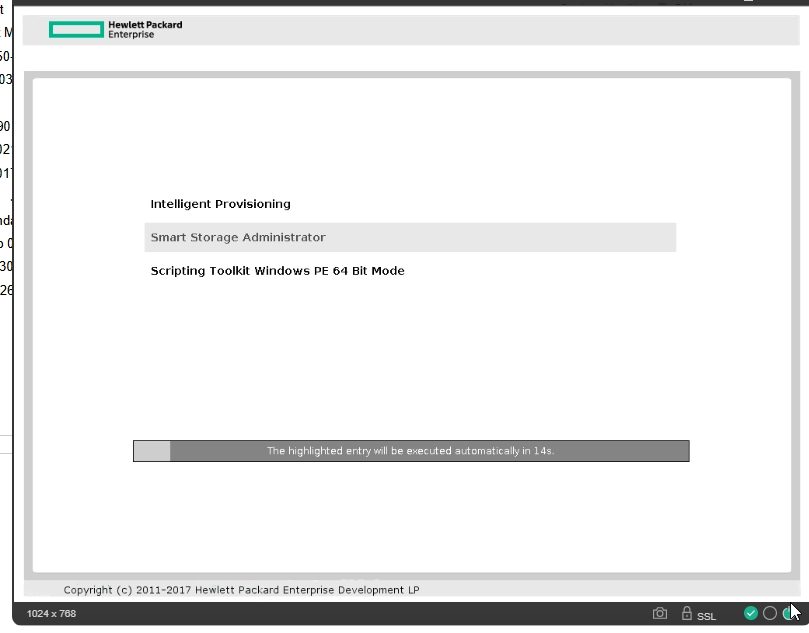

- Exit and launch Samart Storage

.

- Exit and launch Samart Storage

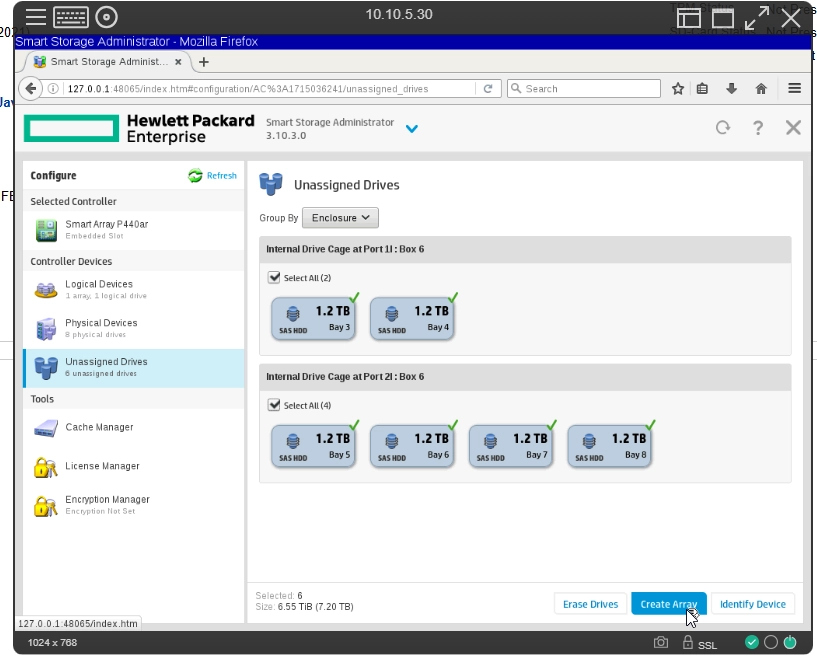

- Gehen Sie zu ihren RAID Controler-> Configure

- Gehen Sie auf Unassigned Drivers

- Wählen Sie die Disks aus für das RAID

- Evtl müssen Sie das alte/vorhandene RAID zuerst löschen. Dies macht man unter Logical Devices

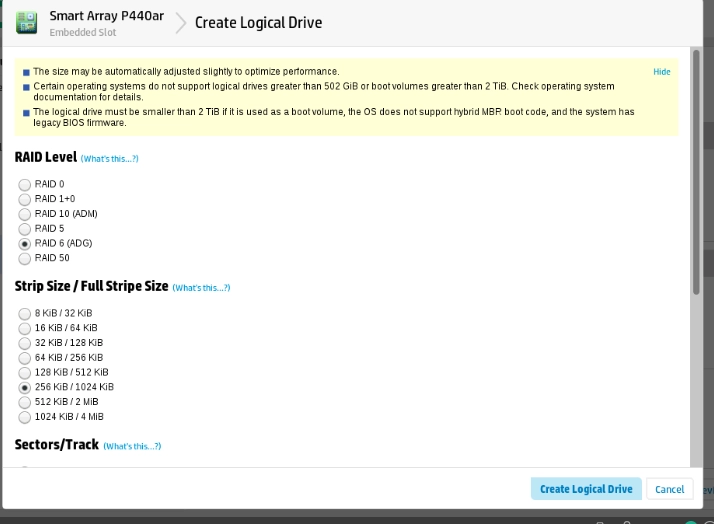

- Nachdem Sie auf Create Array geklickt haben können Sie auswählen welches RAID Sie wollen.

- Je nach Situation macht ein anderes RAID Sinn. Deshalb sehen Sie unten ein Vergleich verschiedene RAID-Arten.

- Eine kleinere Stripe Size ist für viele kleine Dateien.(z.B VMs, Datenbanken) Eine grössere Stripe Size ist für grosse Dateien.(z.B Backups, Videos) Wählt man die Stripe Size richtig werden die Festplatten effizienter.

- Nachdem das gewünschte RAID ausgewählt wurde, kann man auf Create Logical Drive klicken.

- Je nach Situation macht ein anderes RAID Sinn. Deshalb sehen Sie unten ein Vergleich verschiedene RAID-Arten.

Verschiedene RAID-Arten

Legende & Annahmen

- n = Anzahl der Disks im Array (gesamt).

- d = Kapazitaet der kleinsten Disk im Array (z. B. 10 TB). Gemischte Groessen richten sich immer nach der kleinsten Platte.

- Nutzbare Kapazitaet wird konservativ als Formel mit

nunddangegeben. - Beispielwerte: Standard-Beispiel ist

n = 6,d = 10 TB. Wenn ein RAID-Level mehr Disks benoetigt, wird das Beispiel im Feld entsprechend angepasst. - Performance (Lesen/Schreiben) sind Tendenzen; reale Werte haengen von HDD/SSD, Controller, Cache (BBU/BBWC), Datei-/Blockgroesse und Workload ab.

- Ausfalltoleranz: Worst/Best beschreibt die Spannweite je nach Verteilung der Defekte (z. B. pro Mirror/Gruppe/VDEV).

| RAID-Level | Min. Disks | Nutzbare Kapazitaet (Formel) | Beispiel | Performance (Lesen/Schreiben) | Ausfalltoleranz (Worst/Best) | Best Practices |

|---|---|---|---|---|---|---|

| RAID 0 (Striping) | 2 | n · d | n=6, d=10 TB → 60 TB | Sehr gut / Sehr gut | 0 / 0 Disks | Nur für Temp/Non-Critical; immer externes/Offsite-Backup. |

| RAID 1 (Mirroring) | 2 | 1 · d (klassischer 2er-Mirror) | n=2, d=10 TB → 10 TB | Gut / Mittel | 1 / 1 Disk (bei 2 Disks) | Gleiche Modelle/Firmware; Hot-Spare bereit; regelmaessiges Scrubbing. |

| RAID 5 (Striping + 1x Paritaet) | 3 | (n − 1) · d | n=6, d=10 TB → 50 TB | Gut / Mittel–langsamer (Write-Penalty) | 1 / 1 Disk | Nicht für sehr grosse HDD-Pools; Controller-Cache (BBU/BBWC) nutzen; Rebuild-Zeiten beachten. |

| RAID 6 (Striping + 2x Paritaet) | 4 | (n − 2) · d | n=6, d=10 TB → 40 TB | Gut / Langsamer (Write-Penalty) | 2 / 2 Disks | Empfohlen für grosse SATA/NL-SAS-Pools; regelmässig Scrub/SMART; URE-Risiko im Blick behalten. |

| RAID 10 (1+0, Mirror of Stripes) | 4 (gerade Zahl) | (n / 2) · d | n=6, d=10 TB → 30 TB | Sehr gut / Gut (IOPS-stark) | Worst: 1 Disk Best: ⌊n/2⌋ (je 1 pro Mirror) |

Bevorzugt für DB/VM-Hosts; keine gemischten Grössen; Mirror-Paarung sauber planen. |

| RAID 01 (0+1, Stripe of Mirrors) | 4 (gerade Zahl) | (n / 2) · d | n=6, d=10 TB → 30 TB | Sehr gut / Gut | Worst/Best: 1 Disk | Weniger robust als RAID 10: Nach erstem Ausfall ist die andere Hälfte kritisch. |

| RAID 50 (gestreifte RAID-5-Gruppen) | 6 (z. B. 2 Gruppen × 3) | (n − g) · d (g = Anzahl RAID-5-Gruppen) | n=6, g=2, d=10 TB → 40 TB | Zwischen RAID 0 und RAID 5; bessere Skalierung | Worst: 1 Disk (2 in gleicher Gruppe = Fail) Best: g Disks (1 je Gruppe) |

Gruppen gleich gross halten; Rebuild-Zeiten planen; Controller-Cache nutzen. |

| RAID 60 (gestreifte RAID-6-Gruppen) | 8 (z. B. 2 Gruppen × 4) | (n − 2g) · d (g = Anzahl RAID-6-Gruppen) | Beispiel (n=8, g=2, d=10 TB) → 40 TB | Gut / Langsamer (Write-Penalty), hohe Resilienz | Worst: 2 in einer Gruppe (3 = Fail) Best: 2g (je Gruppe 2) |

Fuer sehr grosse Pools; regelmaessig Scrub; Spare-Disks vorhalten. |

| ZFS RAIDZ1 / RAIDZ2 / RAIDZ3 (pro VDEV) | 3 / 4 / 5 | (n − p) · d (p = 1 / 2 / 3) | Ein VDEV mit n=6, d=10 TB → Z1: 50 TB, Z2: 40 TB, Z3: 30 TB | Gut / Mittel bis langsamer (Write) | 1 / 2 / 3 Disks (pro VDEV) | ECC-RAM empfohlen; VDEVs nicht mischen; Snapshots & Send/Receive für Backups nutzen. |

Wichtiger Hinweis: RAID ersetzt keine Backups. RAID schuetzt gegen Hardware-Ausfaelle, nicht gegen Fehlloeschungen, Ransomware oder Site-Desaster. Immer externe und Offsite-Backups pflegen.

Related Articles

December 31st 2025

Wie installiert man Active Directory?

October 31st 2025

Grundkonfiguration vom Windows Server 2025

May 2nd 2025

Effiziente IT-Steuerung mit Group Policy Objects (GPOs): Grundlagen, Nutzen und Einsatz im Server-Umfeld

January 2nd 2025

Wie man Screenshots von ShareX auf einen FTP Server überträgt.

September 10th 2021

RAID system explained

September 3rd 2021

SPOF = Single Point of Failure

June 21st 2021

Jitsi Self-Hosted installation with authentication

February 12th 2021

NodeJS and NPM Setup with basic example

This website was created and developed by LEXO - for more information see LEXO web development